Idoia Salazar | 24 de junio de 2019

El desarrollo de una buena Inteligencia Artificial necesita de una educación ética en valores.

Los conceptos de ética y la inteligencia artificial (IA) están cada vez más unidos. Pero preguntarse por qué no sería en absoluto descabellado. Por un lado, hablamos de una disciplina filosófica que estudia el bien y el mal y sus relaciones con la moral y el comportamiento humano. Por otro, de un sistema informático. Algo intangible y, por supuesto, carente de vida. Sin embargo, la unión de estos dos términos es cada vez más lógica y, a medida que avanza el tiempo y el consiguiente desarrollo tecnológico, su interrelación se ve cada vez más necesaria. Analicemos el porqué.

Ya las propias palabras incluidas en el concepto ‘inteligencia artificial’ generan un cierto contraste. Hasta hace relativamente poco tiempo, la ‘inteligencia’ solo podía asociarse a los seres humanos. Lo podríamos definir como: «Facultad de la mente que permite aprender, entender, razonar, tomar decisiones y formarse una idea determinada de la realidad». Por lo tanto, ‘artificial’ no sería, en principio, un adjetivo adecuado. Las «máquinas» (al menos por ahora) no tienen mente. Sin embargo, los algoritmos sí cumplen otros requisitos implícitos en la definición: la toma de decisiones basada en un análisis -razonamiento- de los datos (estén o no en nuestro cerebro).

Actualmente vivimos en un momento de la historia en el que los datos son la esencia de prácticamente todo lo que nos rodea. En un futuro esta tendencia será mayor aún. El llamado big data crece a un ritmo exponencial a cada segundo que pasa y su gestión por los métodos clásicos es inviable. Es el momento propicio para el desarrollo de una tecnología que nos ayude en este propósito.

La IA no es nueva, pero sí los factores que la rodean y están impulsando su revolución.

Aunque ya los griegos, a través de su mitología, soñaban con «seres artificiales» y hasta Leonardo da Vinci tuvo su visión práctica con su autómata humanoide alrededor de 1495, no fue hasta mediados del siglo XX cuando los desarrollos tecnológicos posibilitaron un primer acercamiento a lo que conocemos hoy por ‘inteligencia artificial’. En 1950, Alan Turing publicó su famoso artículo «Computing Machinery and Intelligence» (Revista Mind) a través del cual dio a conocer lo que hoy se conoce como ‘El Test de Turing’, una prueba que determina si una determinada «máquina» se puede considerar… o no, inteligente. Y, en 1956, los científicos John McCarthy, Marvin Minsky y Claude Shannon acuñaron este término durante la Conferencia de Darthmounth (Dartmouth College, Hanover, EE.UU).

El llamado ‘big data’ crece a un ritmo exponencial a cada segundo que pasa y su gestión, por los métodos clásicos, es inviable

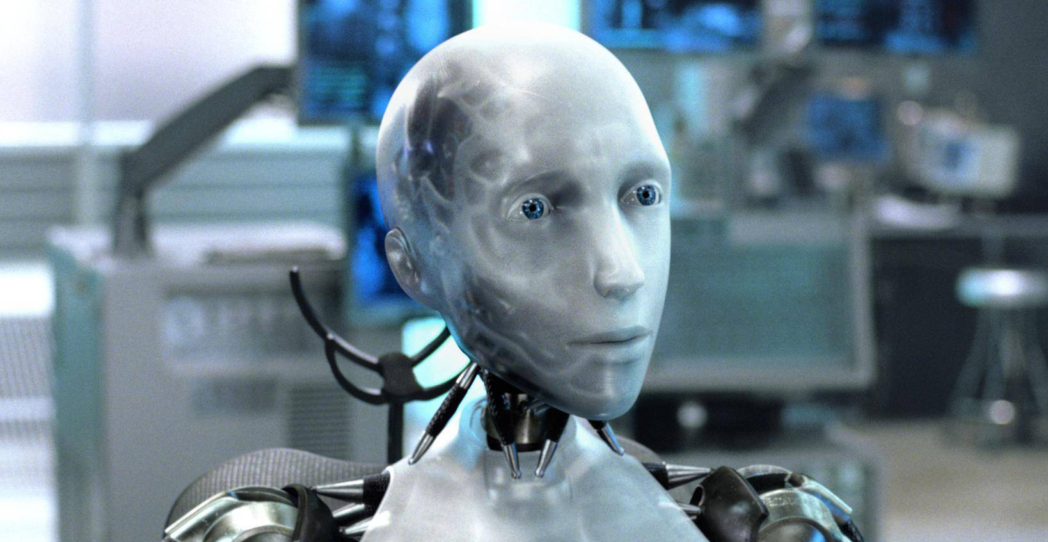

Pero aquel sueño que empezaba a fraguarse se vio reducido a eso, a un mero sueño, a consecuencia de las crisis económicas y la falta de apuesta real por estas tecnologías emergentes. Decididamente, este no era su momento, pero la semilla ya estaba sembrada. En las décadas siguientes, la imaginería sobre «robots inteligentes» continuó con fuerza en la literatura y cinematografía de ciencia ficción. Y ha sido ahora, en estos últimos años, cuando explosión del big data, el incremento de la potencia en la computación y de la capacidad de almacenamiento de datos han posibilitado el despertar de este sueño. Pero este despertar está siendo «dulce» y aún mezclado con la imaginaría precedente. Es lógico por dos razones principales, entre otras menores:

Por un lado, los prejuicios creados por la ciencia ficción nos hacen imaginar que esas «máquinas» similares a los humanos que veíamos en el cine, dominando la Tierra, ahora podrían ser palpables. Por otro, las capacidades de toma de decisiones de los sistemas de inteligencia artificial hace pensar si realmente al ser humano le llegará a quedar algo intrínseco que no pueda ser reproducido de forma artificial.

Actualmente, los algoritmos de IA dependen íntimamente de su programador inicial. Es él quien entrena al modelo y selecciona los datos para ello. Estos sistemas se desarrollan para tareas concretas -no generales-. En función de la importancia o, más bien, relevancia de su labor, la automatización del proceso debe de ser más o menos supervisado. En tareas simples, esa toma de decisiones puede dejarse a la máquina sin que suponga un perjuicio. Pero, ¿qué ocurre cuando esa decisión tiene implicaciones sociales o laborales (por poner un ejemplo) importantes? Al algoritmo de Amazon, que se encargaba de los recursos humanos de la empresa, se le reconocieron sesgos (prejuicios, falta de objetividad) en su toma de decisiones que afectaron directamente a la contratación objetiva de empleados.

Actualmente, los algoritmos de IA dependen íntimamente de su programador inicial. Es él quien entrena al modelo y selecciona los datos para ello

Desde luego, este caso sirvió para aprender la necesidad de vigilar muy de cerca a los datos de los que se alimenta el sistema de IA. Pero falta algo más… Teniendo en cuenta el hecho de que, ahora mismo, son los desarrolladores los que crean y supervisan los algoritmos, su formación específica en las implicaciones sociales que se podrían derivar de esta toma decisiones, y en valores éticos, es fundamental. Esta «educación» debería incluso ascender a las cúpulas empresariales de aquellas compañías que manejan sistemas de IA para fomentar la conciencia real sobre estas tecnologías y actuar en consecuencia.

En un futuro próximo, en el que los algoritmos tomen caminos basándose en su propio aprendizaje, sí será de gran relevancia la implementación técnica inicial de ciertas «normas» éticas (o la «educación de los algoritmos» mediante la manipulación positiva de los datos de los que se alimenta), por supuesto en función de la tarea que desempeñar e incluso del contexto cultural en el que vaya a funcionar. Todo esto influirá de manera determinante en la eficiencia de la decisión tomada por «la maquina» y, por lo tanto, en la aceptación social de estas tecnologías.

En la actualidad hay un gran debate, a nivel internacional, sobre la ética en la inteligencia artificial, pero quizá deberíamos empezar a preguntarnos si la probabilidad de decisiones sesgadas de los sistemas de IA es superior o inferior a la que tendríamos nosotros, los humanos, en ese mismo caso.